Dal silicio al transistor: la storia della computazione elettronica

- Dmitrij Mendeleev e la nascita del metodo scientifico

- I semimetalli (o metalloidi)

- Cosa vuol dire esattamente semiconduttore elettrico?

- Il silicio

- La giunzione P-N

- Il transistor e l'effetto transistor

- I circuiti integrati

- Perché è così importante il numero totale di transistor in una CPU?

- Fin quando sarà possibile miniaturizzare i transistor?

- Quanti transistor contiene un moderno microprocessore?

- Possiamo aiutarti?

Contattaci qui, e ti richiameremo noi!

Quest'articolo è stato aggiornato il giorno: martedì 4 febbraio, 2025

Vi siete mai chiesti di cosa è composto, esattamente, un microprocessore?

Cosa c'è dentro ai circuiti integrati del vostro iPhone, per esempio?

Com'è possibile eseguire, a livello meramente tecnico, calcoli matematici partendo da un comune frammento di silicio?

Se la storia dell'elettronica vi ha sempre affascinato, da amatori, forse potrà esservi utile questo articolo.

Si andrà ad analizzare cosa fa veramente funzionare una porta logica, a livello fisico, in quella che è da tempo chiamata tecnologia silicon gate.

Come molti altri progressi nella storia umana, anche la tecnologia necessaria a far funzionare un sottilissimo iPad Air, ad esempio, è solo il picco di una lunga storia fatta di intuizioni, di fallimenti, di piccoli progressi, di grandi risoluzioni, di molte persone e molti gruppi di lavoro che hanno investito molte vite intere, per raggiungere l'obiettivo del progresso.

Questo, quando utilizziamo il nostro calcolatore anche solo per inviare una banale email, non siamo mai portati a pensarlo. Eppure la tecnologia che ne permette l'utilizzo, è frutto di oltre duecento anni di esperimenti, soldi, tempo ed energie umane.

È impressionante, se ci pensate bene.

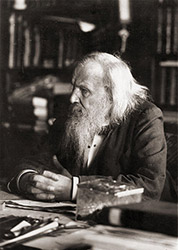

Dmitrij Mendeleev e la nascita del metodo scientifico

Il grande Dmitrij Mendeleev, ritratto in vecchiaia

Nel 1869, un chimico russo si mise di buona lena e tirò giù una serie considerevole di caselle e simboli assortiti, che tentavano di catalogare con raziocinio tutti gli elementi presenti in natura... Beh, almeno tutti quelli allora conosciuti.

Il russo si chiamava Dmitrij Ivanovič Mendeleev ed è universalmente considerato come il padre della chimica moderna.

La sua tavola periodica degli elementi, oltre che ad avere un concetto vincente e tuttora usato, fu anche il primo vero tentativo moderno di processo scientifico.

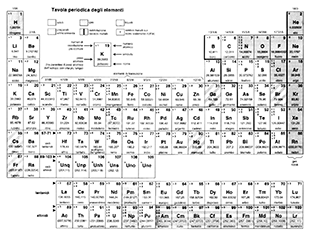

La tavola periodica degli elementi è composta da tutti gli elementi che, si suppone, a loro volta compongano l’intero Universo.

Come ci ricordiamo tutti dalle lezioni di chimica del liceo, nella tavola gli elementi son divisi in Gruppi e Periodi, in base alla loro configurazione elettronica, al loro peso atomico e ai loro elettroni di valenza. Ora, in tutte le rappresentazioni grafiche della tavola, c'è una linea nera che taglia praticamente a metà tutto il grafico. Parte dal boro (gruppo 13) e finisce col polonio (gruppo 16). Bene, quella linea divide i metalli dai non metalli.

A dire il vero le caratteristiche di elementi così vicini in tabella non son mai così nette, quindi possiamo dire che alcuni degli elementi che toccano la riga nera qualcosa hanno in comune. In effetti, son dei semimetalli (o metalloidi). Ciò è ottimo, perché questa categoria ha delle proprietà fisiche e chimiche molto, molto interessanti.

I semimetalli (o metalloidi)

I semimetalli disposti sulla riga nera che taglia in due la tavola periodica, sono:

- Boro

- Silicio

- Germanio

- Arsenico

- Antimonio

- Tellurio

- Polonio

Come già accennato, hanno tutti delle caratteristiche in comune, anche se poi ovviamente le proprietà specifiche cambiano da elemento ad elemento.

Ma la caratteristica comune a tutti i semimetalli, e che ci interessa particolarmente in elettronica, è che sono semiconduttori elettrici.

Cosa vuol dire esattamente semiconduttore elettrico?

Senza addentrarci troppo in fisica, possiamo dire che la conduttività elettrica può essere vista come il livello di resistenza di un particolare materiale (composto o meno) al passaggio di un flusso elettronico. Più il materiale che viene percorso dagli elettroni non oppone resistenza agli stessi, più è considerato un buon conduttore.

Datosi che esiste una precisa costante tra la tensione applicata ai poli di un conduttore e l'intensità della corrente che si viene a creare, è possibile misurare tale costante, che si applica a tutti i conduttori (non solo i metalli). È la legge di Ohm, che ci da anche la misura universale della resistenza, ovvero l'ohm (simbolo Ω).

1Ω corrisponde semplicemente a 1V/1A.

È un altro modo per dire, molto semplicemente, che 1Ω è la resistenza di una corrente di un volt che genera, applicata ad un conduttore, un'intensità di 1A.

Più il conduttore 'resiste' al passaggio degli elettroni, più quindi tensione deve essere data agli stessi, per aumentare l'intensità (l'Ω quindi sale).

Viceversa, il contrario, che poi è chiamato conduttanza, e la sua misura è il Siemens.

È sempre bene ricordare che resistenza e conduttanza sono, ovviamente, grandezze inversamente proporzionali: più un conduttore diminuisce la misura degli Ω, più aumenta la misura dei S (quindi, è un buon conduttore). E, naturalmente, succede il contrario quando il conduttore invece aumenta gli Ω, mentre i S diminuiscono (cattivo conduttore).

Come è facile intuire però, qualsiasi conduttore ha un certo limite di resistenza, oltre il quale, letteralmente, fonde; è l'effetto Joule, che fa riscaldare qualsiasi conduttore percorso da un flusso elettromagnetico.

Questo problema è una vera spina nel fianco dell'informatica, sin dai suoi albori.

In tutta la tavola degli elementi i metalli sono, di norma, da sempre classificati come ottimi conduttori, mentre i non metalli... Beh dipende, ma in genere non sono così eccezionali come conduttanza elettrica (almeno, quando non inglobati in speciali leghe).

I nostri semiconduttori invece, come il nome suggerisce, hanno una caratteristica interessante: possono comportarsi da buoni conduttori oppure, in particolare contesti, possono isolare completamente un flusso elettronico.

E questo, come vedremo poi, è essenziale per costruire una porta logica di una generica CPU.

Il silicio

Ora, si suppone che noi tutti sappiamo, almeno per sentito dire, che le porte logiche che fungono da operatori booleani sono costruite con particolari dispositivi in grado essenzialmente di far passare o meno corrente elettrica, e sappiamo anche che questi costrutti sono chiamati diodi e transistor.

Il materiale usato per costruirli è il semiconduttore silicio, che oltre ad essere particolarmente adatto ai nostri scopi è pure economico e di facile estrazione, visto che sulla faccia della Terra è abbondantissimo (è il secondo elemento più abbondante sul pianeta dopo l’ossigeno).

Nei suoi composti più comuni, si presenta di aspetto lucido, scuro e con riflessi metallici.

È conosciuto dall’essere umano sin dall’antichità, fosse altro perché la sabbia è fatta dai suoi composti.

Il suo nome viene dal latino silex, ovvero selce.

È utilizzato in moltissimi campi industriali, per via non solo della sua qualità di semiconduttore (che a noi interessa particolarmente), ma anche per altre sue caratteristiche proprietarie come una buona resistenza al calore e, opportunamente trattato, la trasparenza.

Di tutte le sue caratteristiche però, quella che è diventata nel tempo sempre più importante è proprio la sua qualità di semiconduttore di corrente elettrica.

Difatti, purificando la silice con un particolare processo di cristallizzazione artificiale (il processo Czochralski) si ottengono dei blocchi di silicio, praticamente puri, pronti per essere trattati e lavorati per costruirci microprocessori, memorie e tante altre cose.

Un blocco di silicio puro, ottenuto grazie al processo Czochralski

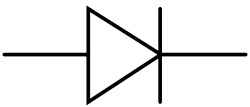

Il simbolo del diodo, usato per rappresentarlo in una generico schema elettrico

Si può dire che un diodo generico (ne esistono di vari modelli, ma il concetto è sempre il solito) sia come una strada a senso unico: si entra da una parte e si esce dall’altra.

Per fare questo, il diodo è lavorato come un blocco solido composto da due zone ben distinte, che son state preparate secondo un ben preciso procedimento chiamato drogaggio.

Tale drogaggio, sebbene il nome possa farlo apparire illegale, è invece perfettamente rispettoso della legge e non ha niente a che vedere con l’uso di sostanze stupefacenti, ma bensì si limita a invadere il blocco di silicio puro di atomi di altri elementi, in genere boro, fosforo e germanio (ma l’uso di altri elementi è di solito a discrezione del produttore): tale accorgimento è mirato a far praticamente “collassare” l’equilibrio elettrico del cristallo (che è sempre neutro) e a far apparire delle zone di eccedenza di elettroni (chiamate strato N, per negativo) contrapposte invece a zone in cui si hanno mancanze degli stessi (strato P, positivo) chiamate lacune.

La cosa importante da notare è che il drogaggio crea due zone ben distinte, ma comunque il cristallo di silicio rimane neutro, in quanto lacune ed elettroni sono comunque bilanciati, nel complesso.

Analizzando meglio, mentre lo strato N può essere visto come un surplus di elettroni (che sono particelle fisiche), la lacuna è in pratica una zona dove questa eccedenza non v’è.

Non è una particella unitaria quindi, ma poco importa perché le sue caratteristiche la possono far vedere come se tale fosse: quindi in gergo, è chiamata anche quasiparticella, ed è schematizzata convenzionalmente come una zona dove “manca” un elettrone.

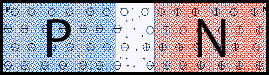

La giunzione P-N

Questo divario elettronico nella mappatura del nostro cristallo venutosi a creare con il drogaggio di un cristallo di silicio è fondamentale, perché come tutti sappiamo le cariche elettriche negative e positive si attraggono, mentre le cariche di segno eguale si respingono (per la legge di Coulomb).

Tutto ciò è regolato da una delle quattro forze di interazione principale che regolano l’Universo, ovvero la forza elettromagnetica.

Questa forza è sfruttata nella vita quotidiana incessantemente in molti di contesti, e quando è applicata ad un cristallo di silicio pieno di strati N e strati P, il risultante, che a noi interessa molto, è chiamato giunzione P-N.

Allo stato attuale della tecnologia, la giunzione P-N generata per mezzo di diodi e transistor permette la costruzione di porte logiche, che a loro volta permettono il calcolo automatico regolato da un flusso elettronico.

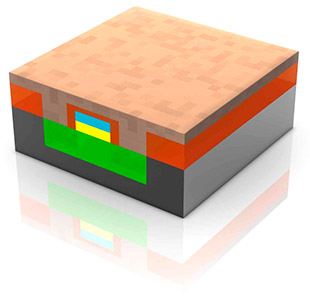

Vediamo la foto qui in basso:

Quella zona evidenziata in blu è stata drogata opportunamente con atomi di boro, ed è diventata una lacuna (o strato P), mentre la zona rossa, invece, è stata drogata con atomi di fosforo ed è diventata uno strato N.

Nella zona (sottilissima) dove i due strati si uniscono (evidenziata ed bianco, ed ingigantita), e le rispettivi elettroni e lacune si ricombinano. È la zona di svuotamento, cuore della giunzione P-N.

Nella regione di svuotamento, la ricombinazione delle cariche crea una zona neutra (si dice svuotata).

Essenziale per il buon esito del fenomeno fisico è che la zona di svuotamento sia sottilissima.

Se ora proviamo a polarizzare (cioè fornire corrente elettrica) il diodo, e lo facciamo in polarizzazione diretta, ovvero rispettando la polarità di catodo ed anodo, vediamo che il flusso elettronico eguale 'spinge' gli elettroni l'uno contro l'altro. La zona di svuotamento quindi si assottiglia.

Gli elettroni dello strano N “bucano” la sottile zona di svuotamento e vengono così attratti dalle lacune dello strato P. Si muovono di lacuna in lacuna attratti elettricamente dalla carica opposta, fino ad uscire dall’anodo, sempre attratti dalla corrente generata dall’alimentazione.

Questo chiude il circuito.

Sotto polarizzazione diretta, la zona di svuotamento si assottiglia sempre di più, schiacciata dalle lacune e gli elettroni.

Ad un certo punto, opporrà una resistenza bassissima, e gli elettroni dello strato N passeranno nello strato P. Il circuito quindi viaggia in una sola direzione, ed il diodo compierà il suo lavoro: polarizzare perennemente il circuito.

Se invece fornissimo una polarizzazione indiretta, ovvero a poli invertiti, la zona di svuotamento si allargherebbe, poiché gli strati P e N tenderebbero ad essere attirati verso i poli elettrici a loro opposti.

La resistenza della zona di svuotamento così aumenterebbe, e diventerre insuperabile per gli elettroni dello strato N. Il circuito quindi non si chiuderebbe.

Ecco perché il diodo si comporta come una vera e propria 'strada a senso unico'. E questo è di fondamentale importanza, quando si progetta un circuito elettronico e si deve, per esigenze di architettura, forzare gli elettroni a percorrere in sola direzione.

Ma se fosse composto solo da diodi, un generico circuito integrato di una generica CPU non potrebbe mai funzionare... Ed ad onor del vero, non potrebbe proprio esser progettato.

Perché il diodo è utilissimo, ma non è un componente attivo. In altre parole: non può, di per sè, controllare direttamente il passaggio di corrente, e né tantomeno smistarlo e amplificarlo.

Al massimo, si limita a costringere il flusso elettronico a percorrere la strada sempre nello stesso verso, ma non è di certo un 'vigile' che può indirizzare il traffico. E non può neppure aumentare il flusso delle macchine.

Ora, il problema è che qualsiasi algoritmo impone delle scelte, che devono necessariamente essere fatte per mezzo di un controllore... Uno switch, diciamo.

Tale switch, dovrà essere usato per aprire o meno un circuito, che può essere uno dei tanti percorsi elettronici possibili, in sede di calcolo.

Ciò ha rappresentato un grossissimo problema agli albori dell'informatica, quando il 'controllore' per tali swtich non era di semplice costruzione, e né tantomeno di minimo ingombro.

Una valvola termoionica, chiamata anche triodo

Esatto, parliamo delle tanto famigerate valvole termoioniche... Un simbolo dei pionieri dell'informatica, diciamo.

Fortunatamente, se i nostri calcolatori ora non ingombrano più due piani di un palazzo, ma possiamo metterceli in tasca, lo si deve essenzialmente ad un semi-sconosciuto ingegnere americano, chiamato Russell Ohl.

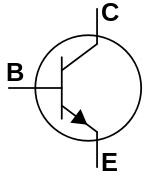

Il transistor e l'effetto transistor

Il simbolo del transistor N-P-N

Nel 1939, il già citato ingegnere americano Russell Ohl scoprì in maniera del tutto casuale il bizzarro effetto della giunzione P-N di cui abbiam parlato poco prima.

Ci si mise a lavorare sopra di buona lena e se ne uscì fuori con un dispositivo che, grossomodo, era concettualmente uguale a quelli utilizzati sin ora: era nato il primo transistor della storia.

Questo favoloso componente sfrutta la funzione P-N, proprio come accade nei diodi, ma ha anche un’altra curiosissima caratteristica che lo rende unico e, dopo più di 60 anni dalla sua invenzione, ancora ineguagliabile: è capace infatti non solo di fare da interruttore per un circuito elettrico, ma anche di comportarsi da triodo, ovvero amplificare un segnale in ingresso.

Già, proprio come le valvole termoioniche.

Purtroppo, Ohl non brevettò mai la sua invenzione e così sul finire degli anni ’50 ci pensarono alcuni ingegneri della Bell a farlo per lui, e ci presero pure un Nobel.

In poco tempo dalla sua produzione industriale, il transistor ha completamente sostituito qualsiasi valvola.

Beh, più o meno, perché ancora per certe tensioni (elevatissime) si usano speciali valvole termoioniche.

Comunque, nei lustri si son prodotti centinaia di tipi di transistor, per tutti gli usi e per tutte le esigenze.

Ovviamente e come vedremo in seguito, per costruire le porte logiche di una qualsiasi ALU vengono usati particolari tipi di transistor, veramente microscopici, sull'ordine dei 22 nm (nanometri). Per farvi capire: 1 nm corrisponde ad un miliardesimo di metro, e di 2 nm è la misura della doppia elica del nostro DNA.

Pensate quindi quant'è piccolo un moderno transistor!

Ma come effettivamente lavora il transistor, ed il suo effetto di amplificatore e di interruttore.

Nulla di così complicato, c’è ancora di mezzo la giunzione P-N, solo che stavolta cambia il numero di strati.

Come già ricordato, ci sono un numero considerevole di tipi di transistor; il più semplice da spiegare (ed uno dei più utilizzati) è il transistor bipolare.

In questo transistor, gli strati drogati non sono più due, ma tre: base, emettitore e collettore.

Gli strati P e N, sono messi a 'sandwich', e quindi è possibile metterne in combinazione come P-N-P oppure N-P-N. Le zone di svuotamento, quindi, sono due.

La corrente in entrata, con polarizzazione diretta, viene applicata ad emettitore e base, che quindi fungono da controllo.

La corrente in uscita, viene espulsa dal collettore.

L'effetto transistor, ovvero la sua capacità di chiudere il circuito ed amplificare il segnale, si ottiene modificando la tensione della corrente della base e dell'emettitore: oltre una certa soglia di volt (diciamo, 5V), la zona di svuotamento base-emettitore diventerà così sottile che gli elettroni saranno attratti verso l'emettitore, dove si creerà un potente vortice elettronico che 'risucchierà' gli elettroni dall'emettitore verso un altro circuito collegato, e che amplificherà la tensione in uscita.

Così, con una piccola tensione applicata a base-emettitore, possiamo sfruttare unatensione ben maggiore in uscita dal collettore, e controllare quindi un secondo circuito, amplificato. In pratica, fa il lavoro che fa un triodo termoionico.

Proprio per il suo comportamento da triodo, quindi, spesso il transistor è chiamato triodo a stato solido.

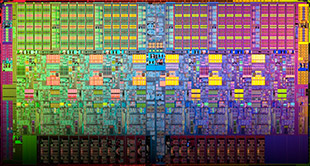

I circuiti integrati

Diodi e transistor cominciarono ad essere prodotti industrialmente su scala mondiale verso la fine degli anni '60.

Grazie alle proprietà della giunzione P-N, che rimangono invariate anche su superfici piccolissime, si cominciarono a miniaturizzare radio, televisori, impianti sterofonici... Di tutto.

Ovviamente, tale tendenza venne sfruttata anche dall'industria dell'elettronica, sebbene, almeno fino al 1971, ancora nessuno si era preso la briga di riunire tutti i componenti di una CPU (ALU, Control Unit, cache, ecc ecc.) in una singola unità.

Ci pensò il più grande ingegnere elettronico del 1900, l'italiano Federico Faggin, al tempo impiegato presso Intel.

Ferrico Faggin, universalmente riconosciuto come uno dei più grandi ingegneri elettronici di sempre.

Al suo pioneristico lavoro si deve la produzione attuale dei microprocessori, l'invenzione del trackpad, il bootstrap, la tecnica dei circuti ad alta densità... E tante altre cose.

Faggin riuscì a progettare un circuito generale con integrati tutti i circuiti specifici delle singole unità che compongono una CPU, e lo fece su uno spazio piccolissimo, di neppure 2 cm quadrati.

Era nato il primo microprocessore a circuito integrato della storia, l'Intel 4004.

Il primo microprocessore della storia: l'Intel 4004, costruito da Federico Faggin

Per ottenere un integrato così piccolo, Faggin scelse di non assemblare i componenti su una base, ma di inciderli direttamente in un unico blocco di silicio, opportunatamente drogato, secondo lo schema dei circuiti che doveva contenere.

Tale idea, che diventerà poi lo standard industriale MOS, l'aveva sviluppata poco dopo la laurea in fisica, a Padova, quando era un assistente alla cattedra.

Faggin curò personalmente lo sviluppo e la produzione di tanti altri chip Intel, fino a che, andatosene per mettersi in proprio con la Zilog, progettò il microchip più prodotto in assoluto della storia: il famoso Z-80, che viene tutt'ora impiegato in molti sistemi embedded.

Con l'Intel 4004, cominciò la grande produzione industriale dei microchip integrati, che continua ai giorni nostri, e con volumi di produzione sempre più elevati.

La tecnologia è riuscita a miniaturizzare i diodi ed i transistor talmente tanto, che ormai in un generico chip dual core, si possono contare circa 2.000.000.000 di transistor, il cui diametro varia dai 90 nm ai 22 nm.

Il numero di transistor presenti in un singolo die aumenta all'aumentare del numero di core (nuclei di calcolo) presenti in esso.

Per paragone: il primo Intel 4004 costruito da Faggin, ne contava 4.300.

Perché è così importante il numero totale di transistor in una CPU?

Modello 3D di un generico transistor CMOS. Immaginatelo più piccolo almeno di... Beh, qualche miliardo di volte, rispetto all'immagine

Per la sua stessa architettura (chiamata "architettura di von Neumann" in onore del grande matematico americano John von Neumann, di origini ungheresi, che ha per primo ideato lo schema principale che usano praticamente tutti i calcolatori odierni), una CPU è in circuito integrato sincrono, composto da altri circuiti, ognuno con una specifica funzione.

Principalmente, la parte che si occupa di eseguire i calcoli artimetici (sottrazione, addizione, moltiplicazione, divisione), è chiamata ALU, acronimo di Arithmetic and Logic Unit (Unità Aritmetica e Logica).

L'ALU, assieme ai registri sulla quale lavora, sono il core principale della CPU. I circuiti formati dalle porte logiche presenti sull'ALU, anche se in teoria potrebbero eseguire ogni tipo di calcolo, nella realtà odierna sono estremamente specializzati: troviamo circuiti dedicati all'estrazione della radice quadrata, all'elevamento a potenza, al calcolo specifico di specifici logaritmi.

Insomma: l'ingegnere elettronico, o meglio l'equipe che progetta una data ALU, anche se teoricamente potrebbe ideare un circuito universale, per tutti i calcoli, tende sempre a dividere il lavoro in più 'sotto-ALU', che lavoreranno poi in parallelo.

E questo, per un motivo semplice: un'ALU che esegue tutte, ma proprio tutte, le operazioni logiche, sarà molto compatta (e costosissima) è vero, ma risulterà essere un pachiderma disumano, estremamente lento rispetto alle ALU con sotto-unità specifiche.

Ecco che quindi, rimpicciolire sempre più i transistor, permette semplicemente di creare più circuiti dedicati per le ALU, che così potranno 'smezzarsi il lavoro', elaborando in parallelo.

All'inizio degli anni 2000, il concetto di parallelismo è diventato prioritario, per i costruttori mondiali di CPU. Anche perché si era raggiunto il limite accettabile di frequenza di clock, ed i processori oltre i 3 Ghz cominciavano a dare un'enormità di problemi (calore, in primis).

Il numero totale di transistor in una generica CPU è solitamente dato dalla famosa legge di Moore.

Sebbene empirica, questa 'legge' teorizzata per primo dal famoso Gordon Moore (cofondatore dell'Intel) quasi esclusivamente su riscontri pratici e produttivi (non matematici), dice che "Il numero di transistor in un dato processore, raddoppia ogni 18 mesi".

Sarebbe bene sottolienare, però, che lo stesso Moore ha sempre dichiarato che aveva formulato questo assioma all'inizio della produzione industriale di microprocessori, agli inizi degli anni '70 del 1900, quando i transistor non avevano raggiunto i 22 nm attuali.

Prima o poi, e questo è risaputo da molto tempo, non sarà più possibile assottigliare i layer di silicio che contengono i transistor senza aver grossi problemi con la fisica che governa l'infinitamente piccolo: la meccanica quantistica.

Fin quando sarà possibile miniaturizzare i transistor?

Il primo SoC con CPU ARM a 64bit (dual core) del mondo: Apple A7

Come detto prima, la miniaturizzazione di diodi e transistor non può andare avanti all'infinito, perché il silicio su cui sono incisi ha dei limiti fisici.

Anzi, quantistici, è il caso di dirlo.

Scendendo sotto un certo limite, che è stato stimato di circa 11 nm, le leggi della meccanica classica lasceranno il posto a quelle della meccanica quantistica, che governa il mondo del particellare.

Arriverà un punto, quindi, in cui non sarà più possibile incidere transistor sotto un certo diametro, perché l'effetto tunnel sarà ingovernabile, e gli elettroni si ritroverebbero ad avere energia sufficiente ad attraversare qualsiasi barriera di ossido che li separa dalle lacune.

Il problema è di non facile soluzione, ed è anche per questo che, per ora, si stanno ricercando e studiando metodi alternativi ai transistor in silicio.

Stimare quando si raggiungerà il limite invalicabile è abbastanza difficile: come detto in precedenza, la legge di Moore sembra perdere validità oltre una certa soglia di produzione (sempre più vicina ai famosi 11 nm che sono il limite teorico).

D'altro canto, è anche vero che i costi di produzione di chip vecchi, collassano di metà in metà nel tempo: questo, permette di costruire sistemi embedded sempre più performanti usando vecchi chip ormai disponibili a bassissimo costo (si para di centesimi, anche per gli un tempo costosissimi Intel Pentium o i PowerPC G3 e G4).

Se i chip ARM da oltre 1 Ghz montati sui recenti iPhone ed iPad possono vantare prestazioni superiori al miglior sistema desktop disponibile nel 2002 (è solo un esempio), lo dobbiamo senza dubbio a quanto detto sopra.

Non è escluso, comunque, che la classica tecnologia silicon gate non possa essere in futuro affiancata, in un sistema diciamo 'ibrido', ad altra tecnologia, come ad esempio i molto promettenti nanotubi in carbonio, od anche la computazione a DNA.

Quanti transistor contiene un moderno microprocessore?

Il package di una GPU AMD Firepro da circa 5.000.000.000 di transistori

Per la Legge di Moore illustrata poco sopra, è una domanda che ha una risposta quanto mai variabile: prendendo per buona la legge, il numero di transistor dovrebbe raddoppiare ogni anno e mezzo, fino a quel limite di 11 nm che è ancora ipotetico.

In realtà, già con la generazione dei Intel Pentium - in particolar modo il modello Pentium 4 con i suoi 184.000.000 di transistor - il limite massimo fisico sarebbe già stato quasi raggiunto, e si deve considerare che il processo costruttivo per quel modello è di 90 nm.

Impossibilitati giocoforza ad andare oltre col numero di transistor per un singolo chip, Intel, AMD, ARM e compagnia tutta si sono concentrate sul calcolo a multi-core, che è diventato l'asse portante dell'elettronica dei semi-conduttori già a metà anni 2000.

Sommando il numero dei transistor di ogni core, la Legge di Moore sembra essere ancora valida: ad esempio, nel 2015, Apple mise sul mercato il chip A8X, un eccezionale tri-core per dispositivi mobili di ben 3.000.000.000 di transistor.

Sempre nello stesso periodo, Intel mise a punto la serie a ben 18 core E5 dei suoi Xeon, con architettura Haswell, di circa 5.500.000.000 di transistor.

Sempre al 2015, lo SPARC M7 di Oracle era il microprocessore col più alto numero di transistor disponibile sul mercato: 10.000.000.000.

Tuttavia, è stato più volte detto (e dimostrato) che la Legge di Moore è niente più che una traccia generica, basata su una scala di produzione che, forse, ha fatto molto del suo tempo.

Attualmente, gli sforzi di Intel, AMD e ARM non vergono tanto sull'aggiungere più transistor ai loro core, ma piuttosto a migliorare il consumo energetico ed ottimizzare il lavoro in parallelo.

Sul lato delle GPU, il discorso è più o meno il medesimo: il co-processore grafico ha subito lo stesso destino del suo compagno principale, e vede le moderne schede grafiche (AMD Radeon e GeForce NVIDIA, in primis) assestarsi sui 5.000.000.000 di transistori per core.

Con l'avvento, anzi meglio dire vera e propria 'esplosione' del mercato mobile, anche per i co-processori grafici lo sforzo dei produttori è tutto nel risparmio energetico e nell'ottimizzazione delle risorse sinora prodotte: non a caso, i sistemi SoC, e la soluzione di integrare il core della GPU direttamente nella CPU, è ormai un fatto assodato.

Dal 2012, Apple monta sulla sua gamma di MacBook, MacBook Pro ed anche iMac una GPU integrata nella CPU Intel: gli sforzi delle due società, in tal senso, hanno aperto la strada a questa tendenza, che poi è stata adottata da tutti gli altri produttori hardware.

I risultati si vedono: dai chip grafici integrati Intel HD 3000 agli Intel Iris il numero di transistori è raddoppiato, e la potenza di calcolo aumentata di svariate lunghezze.

Non c'è quindi alcun dubbio che il calcolo parallelo abbia permesso alla Legge di Moore di esistere fino ai nostri giorni, sebbene le previsioni di una sua futura validità, specie sul lungo periodo, siano decisamente aleatorie.

Molto probabilmente, e questa non è una pura speculazione ma un'analisi basata su fatti oggettivi, il calcolo parallelo (che è già in essere, sebbene poco sfruttato, almeno dal 2005) diventerà lo standard dell'industria dei semiconduttori. Almeno finché nuove tecnologie, come la già citata computazione a DNA, non saranno economicamente sostenibili.

Possiamo aiutarti?

Sperimenti problemi col tuo iPhone, iPod, iPad o Mac, e vuoi affidarti a dei professionisti?

Siamo qui per ascoltarti ed aiutarti.

Offriamo solamente servizio in loco in tutta Milano, non abbiamo una sede fisica: ciò ci permette di risparmiare sui costi e garantire prezzi e tempi d'intervento eccezionali!

Compila il modulo qui sotto per metterti in contatto con uno dei nostri tecnici.

Paolo

Ramona

Carlo

Abbiamo i prezzi più bassi del mercato, ma non rinunciamo mai alla qualità.

Lasciamo volentieri agli altri componenti di bassa qualità.

In aggiunta, ad ogni cambio di schermo, digitizer, LCD, assembly completo e batteria, il vostro dispositivo viene accuratamente controllato, pulito da eventuali polveri e/o altre impurità e consegnato solo dopo un preciso esame (in cui viene eseguito uno stress test di iOS, viene verificato il funzionamento delle fotocamere, della ricezione GSM, dell'antenna Bluetooth, Wi-Fi... E tante altre cose), atto a verificare l'assoluta perfezione del vostro nuovo schermo.

Perché la vostra sicurezza è importante, così come è importante la vostra soddisfazione.